���C����̃v���O�����̎����ɓ������ẮCGame Programing Gems 4���Q�l�ɂ��Ă��܂��B

Perspective Shadow Maps���@1�D�͂��߂Ɂc

�@Perspective Shadow Maps(�����V���h�E�}�b�v�j�������Ă݂܂����B

���C����̃v���O�����̎����ɓ������ẮCGame Programing Gems 4���Q�l�ɂ��Ă��܂��B  ���@2�DPerspective Shadow Maps�Ƃ́c

�@Perspective Shadow Maps�́CStamminger��Drettakis��SIGGRAPH 2002�Ŕ��\�����V���h�E�}�b�v�Ɋւ����@�ł��B(

�_���͂�����̃y�[�W)

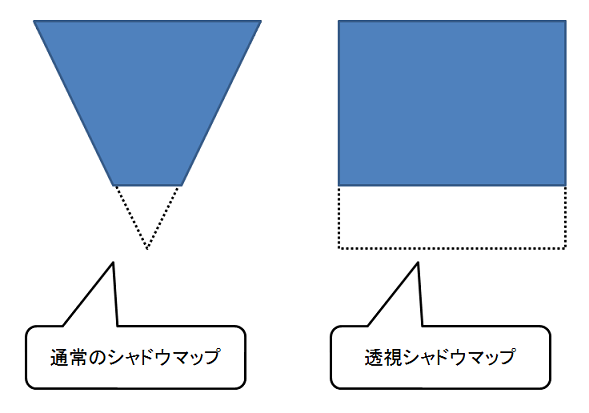

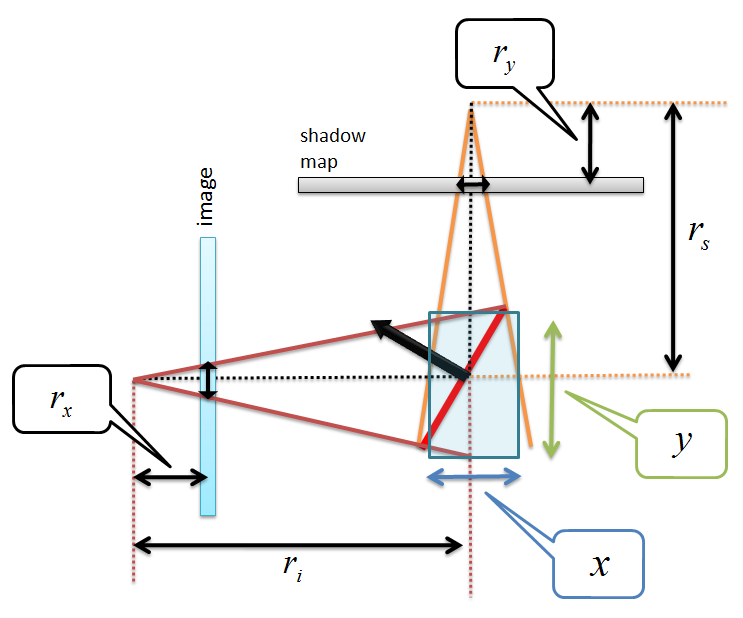

�@�V���h�E�}�b�v�́C�e�����邽�߂̎�@�Ƃ��āC�g���Ă��܂����C�悭�m���Ă����肪����܂��B ����́C�G�C���A�V���O�̖��ł��BPerspective Shadow Map(�����V���h�E�}�b�v�j�́C���̃G�C���A�V���O�̖����������邽�߂̈�̎�@�ł��B�����V���h�E�}�b�v�͐��K�����ꂽ�f�o�C�X���W��ԏ�Ő������܂��B���Ȃ킿�C�����ϊ���̋�ԂŃV���h�E�}�b�v������Ƃ������Ƃł��B���āC���̗l�ɓ����ϊ���̋�ԂŃV���h�E�}�b�v������Ɖ����ǂ��̂ł��傤���H �@���̐}�����Ă��������B �@  �@��̐}�́C�W���̃V���h�E�}�b�v�Ɠ����V���h�E�}�b�v�̈Ⴂ���������̂ł��B��̐}�Ɏ����悤�ɒʏ�̃V���h�E�}�b�v�ł́C����̂悤�Ȍ`�ɂȂ�̂ł����C�����V���h�E�}�b�v�ł́C�����`�̂悤�ɂɂȂ�܂��B�����V���h�E�}�b�v�́C�������e�ϊ����ăV���h�E�}�b�v�����āC���_�ɋ߂������̉𑜓x�����𑜓x�ɂ��Ă����āC�����ɍs���ɂ�Ă���Ȃ�̉𑜓x�ɂ��悤�Ƃ����̂���{�I�ȃA�C�f�A�̂悤�ł��B��̐}������Ɗm���ɁC�ʏ�̃V���h�E�}�b�v�ɔ�ׂāC�J�����ɋ߂������̖ʐς��傫���Ȃ��Ă���̂ŁC���𑜓x�Ő������ꂻ���ȋC�����܂��B �@�܂��C�����V���h�E�}�b�v���u������x�C�g���������Ȃ��`�v�Ƃ����̂͂킩��̂ł����C�����������ŃW���M��̂��Ƃ����G�C���A�V���O�̖��𗝉����Ă����˂Ȃ�܂���B�ŁC�_�����ɃG�C���A�V���O�Ɋւ��鎮���ڂ��Ă���̂ł����C�����Ƃ��܂����悭�킩��Ȃ������̂ł����C�����킩��悤�ɂȂ����̂ŁC���̐��������Ă����܂��B ���@3�D�V���h�E�}�b�v�̃G�C���A�V���O

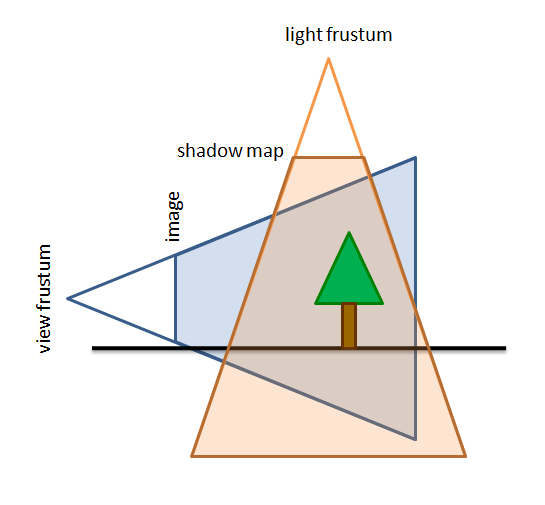

�@���āC�G�C���A�V���O�Ɋւ��Ăł����C�܂��͉��̐}�̂悤�ɃJ���������_�Ƃ������̎��쐍��ƃ��C�g�����_�Ƃ����Ƃ��̎��쐍�䂪����Ƃ��Ă����܂��B�V���h�E�}�b�v��̊e�s�N�Z���́C���̃��C�g�ɂ�鐍������L���Ă��邱�Ƃ������Ă���C�摜��ԏ��ds�~ds�̃T�C�Y�̃V���h�E�}�b�v��ʉ߂��܂��B

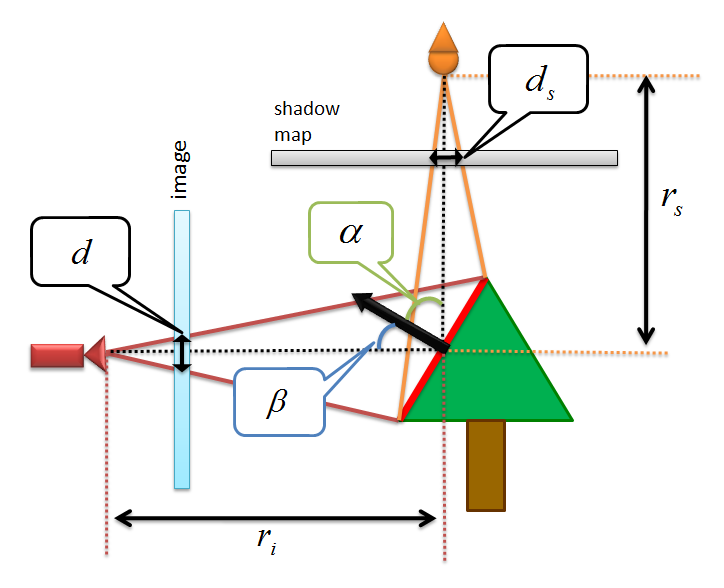

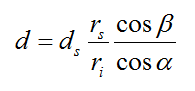

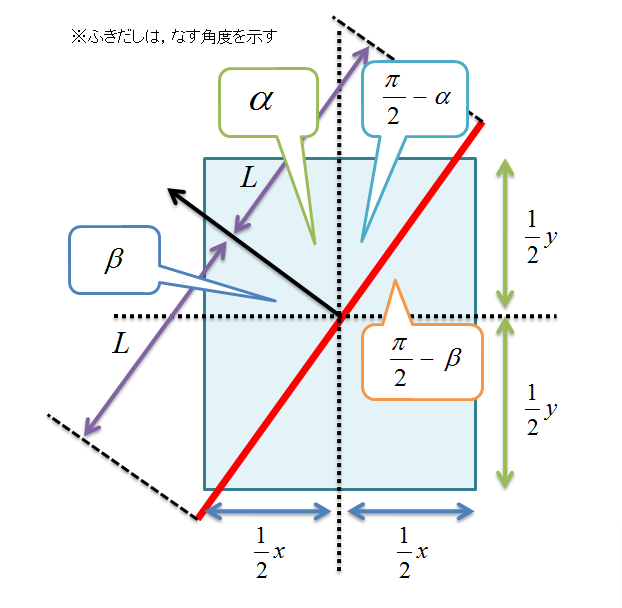

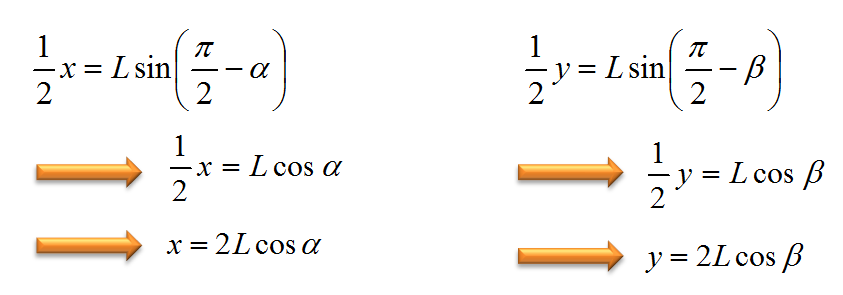

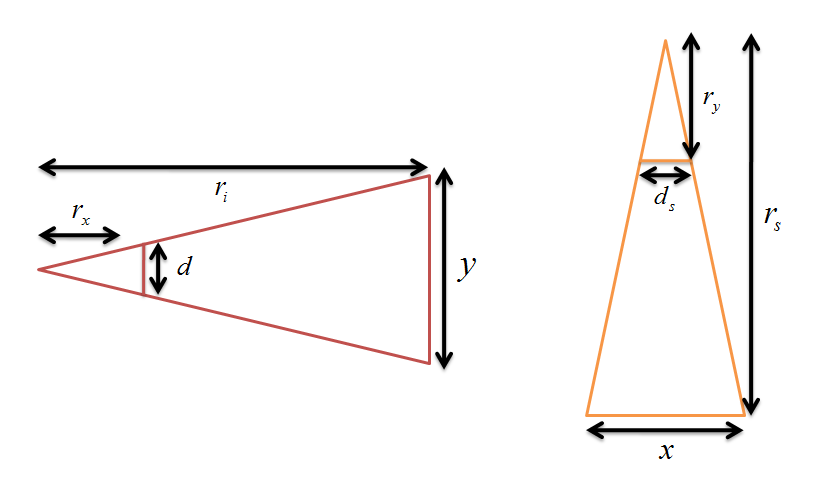

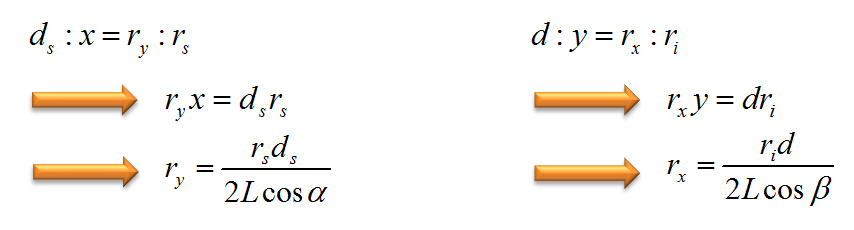

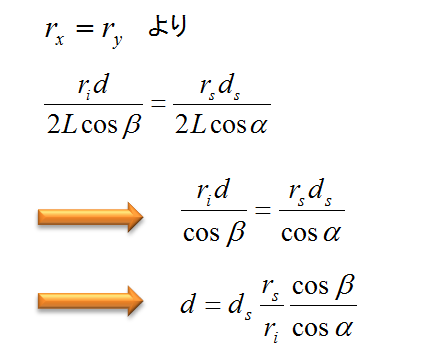

�@���̏̂Ƃ��C���̐}�̂悤�ɃJ��������̎����x�N�g���ƃ��C�g����̎����x�N�g���̌����_������C�J������������_�܂ł̋�����ri�Ƃ��C���C�g��������_�܂ł�rs�Ƃ��܂��B�܂��C�����_�ł̖ʂ̖@���x�N�g�����������ŕ\���C�J�����̎����x�N�g���Ɩ@���x�N�g���̂Ȃ��p�����C���C�g�̎����x�N�g���Ɩ@���x�N�g���̂Ȃ��p�x�����Ƃ����܂��B�܂��C�V���h�E�}�b�v�ɂԂ������Ƃ��̃s�N�Z���̈�ӂ̃T�C�Y��ds�C�ŏI�I�Ƀ����_�����O�������ʂ�\������摜���ʂł̃s�N�Z���̈�ӂ̃T�C�Y��d�ƌ��߂Ă����܂��B  �@����ƁC�摜���ʏ�̃s�N�Z���̑傫��d�͎��̎��ɂ���āC�Z�o����܂��B  �@�����ԁC���̎����ǂ�����ĎZ�o���ꂽ�̂��悭�킩��Ȃ������̂ł����C�����Ȃ�ɗ����ł���悤�ɂȂ����̂ŁC���������Ă������Ǝv���܂��B ���Ȃ݂ɁC�ȉ��̐����́C�Ԉ���Ă��邩������܂���B�L�ۂ݂ɂ���Ȃ��悤�ɂ��肢���܂��B �@�܂��C���̐}�̂悤�ɘ_���ɂ͍ڂ��Ă��Ȃ��ϐ�x, y, rx, ry��u���Ă����܂��B���ƁC�͏����Ă���Ƃ킩�肸�炢�̂ŁC�ȗ����Ă��܂��B  �@�����ŁC�e�ɂȂ�M���M���̏�Ԃ��l���܂��B�e�ɂȂ邩�ǂ����̔���̓J�����̐[�x��\��ri�ƃV���h�E�}�b�v�Ɋi�[����Ă���[�x�lrs�ɂ���Č��܂�܂��B����ĉe�ɂȂ�M���M���̏�Ԃ�rs��ri�̒l����v�����ꍇ�ɂȂ�܂��B����ƁC�j�A���ʂƃt�@�[���ʂ͕��s�ɂȂ�̂ŁC�j�A���ʂ��܂ގO�p�`�ƃt�@�[���ʂ��܂ގO�p�`�͑����ɂȂ�܂��B����āCrs��ri�̒l����v����Ƃ������Ƃ�rx��ry�̒l����v����Ƃ������ƂɂȂ�܂��B�����ŁCrx��ry�̒l�����߂邱�Ƃ��l���܂��B  �@��̐}�͌����_�̕t�߂��g�債�����̂ł��B�@���x�N�g���͖ʂƂȂ��p�x��90�x�ɂȂ�̂ŁC���������̐}�̂悤�ɖʂƃ��C�g�̎����x�N�g���̂Ȃ��p�x��(��/2)-���C�J�����̎����x�N�g���ƖʂƂ̂Ȃ��p�x��(��/2)-���Ƌ��܂�܂��B����āC���̓�̊p�x����x��y�̓��ƃ���p�������̎��ŕ\�����Ƃ��ł��܂��B  �@���ɁC��قǏq�ׂ��悤�ɁC�j�A���ʂƃt�@�[���ʂ͕��s�ł���̂ŁC�j�A���ʂ��܂ގO�p�`�ƃt�@�[���ʂ��܂ގO�p�`�͑����ł��邱�Ƃ��ؖ��ł���̂ŁC���̐}�̂悤�ɑ����̊W�ɂȂ�܂��B  ����āC�����W���玟�̎������藧���܂��B  �@����ł悤�₭�Crx��ry���\���邱�Ƃ��ł��܂����B���Ƃ͏o�Ă���rx��ry���C�R�[���łȂ��܂��B  �@�ꉞ�C�����͂���Ȋ����ŁC�������̂ł����c�����Ă��܂����ˁH�}�̍쐬���w�^�N�\�Ȃ����ŁC���������藧���Ȃ����Ɍ����邩�����܂��c�B �܂��C�Ƃ肠�����_�����ɏ����Ă���d��\�����������Ă���Ƃ��Ă����܂��傤�B �厖�Ȃ̂́C���̈Ӗ��ł��B�܂��́Cdirectional light(�������C�g�j�Ɋւ��čl����ƁCd��ds*(rs/ri)�ɉe�����܂��B�V���h�E�}�b�v�̃G�C���A�V���O��d���摜�̃s�N�Z���T�C�Ydi���傫���Ȃ����Ƃ��ɔ������܂��B�܂�Cds*(rs/ri)�̒l���傫���Ȃ����Ƃ��ɁC�G�C���A�V���O����������\�������܂�܂��B�ϑ��҂��e�̋��E�ɃY�[�������Ƃ��ɂ́Cri�̒������������Ȃ�̂ŁC�G�C���A�V���O���悭���������肷��悤�ł��B�_�����ł́C���̃G�C���A�V���O�̂��Ƃ�Perspective Aliasing�i�����G�C���A�V���O�j�ƌĂ�ł��܂��B���̓����G�C���A�V���O������邽�߂ɂ́C(rs/ri)�̔��������l�ɕۂ��Ƃʼn\�ł��B�����āC�����ۂɂ́C�����ϊ���̋�ԂŃV���h�E�}�b�v������悢�Ƙ_���ɂ͏�����Ă��܂��B�����ЂƂC�����Ȃ�������Ȃ��̂́C���ƃ��Ɋւ��Ăł��B(cos��/cos���j�̒l���傫���Ȃ����Ƃ��ɂ������G�C���A�V���O���������܂��B�T�^�I�ȏꍇ�́C���C�g�̌������n�ʂɂقڕ��s�ł���ꍇ�ł��B���̏ꍇ�͉e���n�ʂɉ����ĐL�тĂ��܂��܂��B ���@4�DPerspective Shadow Map�̎���

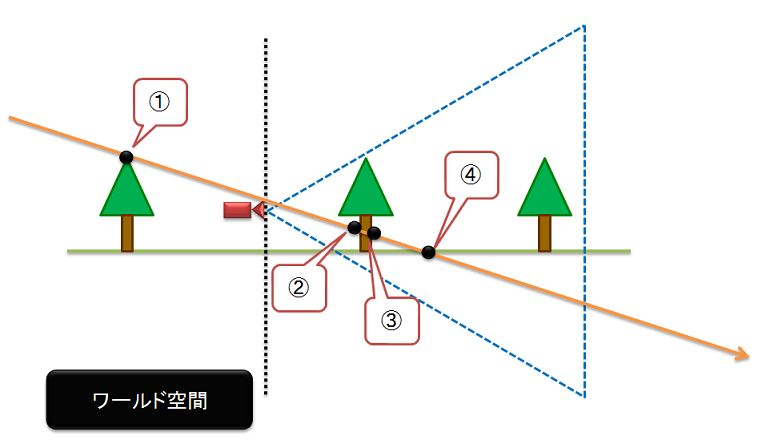

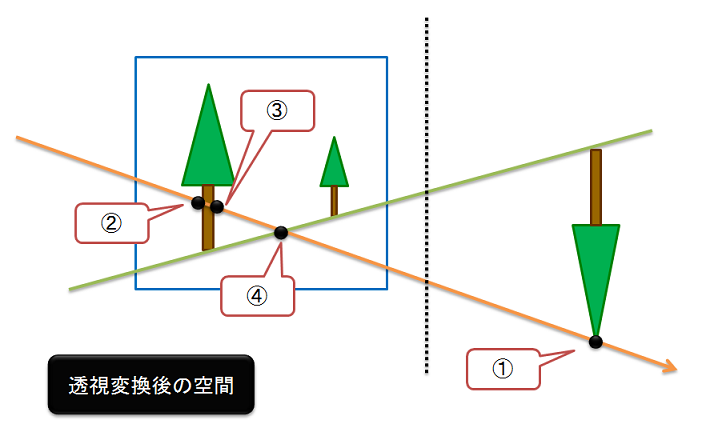

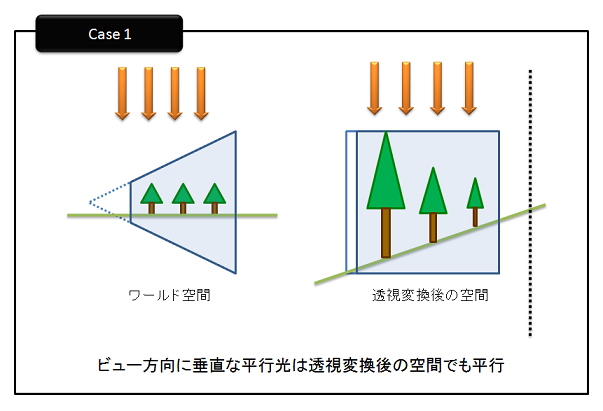

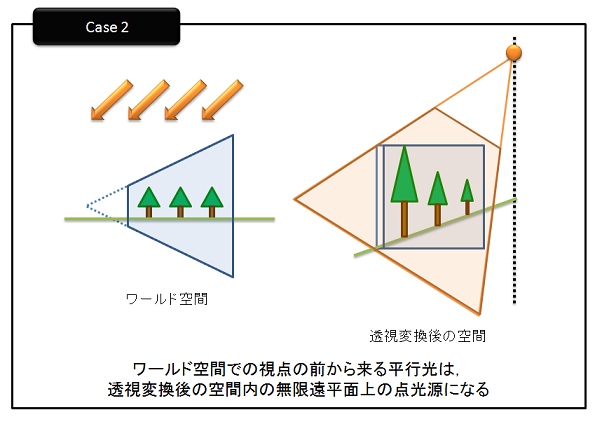

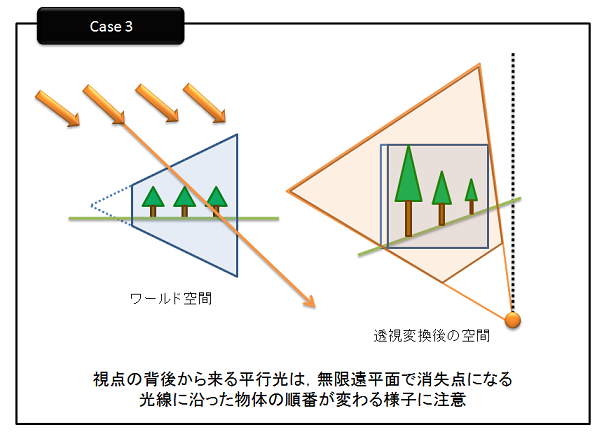

�@���āC�����V���h�E�}�b�v�ł����C�����ϊ���p����̂ŋC�����Ȃ��Ă����Ȃ��_������܂��B�Ⴆ�C���̂悤�ȏꍇ�ł��B

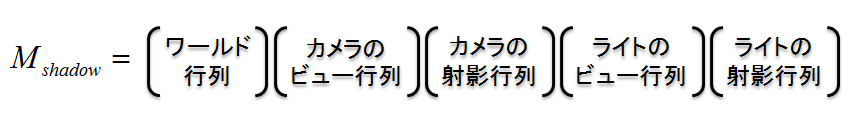

�@�I�����W�F�̐��������C�g����̃��C�Ƃ��܂��B����ƁC���[���h��Ԃł́C���C�ɉ����Č����_�͇@�C�A�C�B�C�C�̏��ɂȂ�܂��B �������C�����ϊ���̋�Ԃōl����Ɓc  �@��̐}�̂悤�ɁC���C�ɉ����Č����_�̏��Ԃ́C�A�C�B�C�C�C�@�ƂȂ菇�����ς���Ă��܂��܂��B ���̖����������邽�߂ɁC�_���ł̓J�����̌�ށC���Ȃ킿�C�V���h�E�}�b�v���ɕ\�����Ȃ���Ȃ�Ȃ��V�[���̂��ׂĂ̓_�����_�̑O�ɂ���܂Ŏ��쐍������ɂ���Ƃ������Ƃ��Ă��Ă��܂��B�m���ɁC���̂悤�ɂ���V�[�����̂��ׂĂ̓_���܂ނ��Ƃ�ۏł��܂��B �@�������C�J��������ނ�����ƁC���ۂɂ̓J�����ɋ߂��I�u�W�F�N�g���������Ȃ�܂��B���̌��ʁC�V���h�E�}�b�v�̎g���Ȃ���Ԃ��L���Ȃ��Ă��܂��Ƃ����V���Ȗ�肪�������܂��B���̕ӂ̓����V���h�E�}�b�v�̖��_�ɂ��ẮCGPU Gems 1�ɏڂ��������Ă���܂��B���݂́CNVIDIA�̃T�C�g�ʼnp��ł��ǂ߂�悤�ɂȂ��Ă���̂ŁC�ڂ����m�肽������������̕������������Ă��������B ����́CGPU Gems1�ɏ����Ă���Practical PSM�̎�@�͎g���܂���B �@���������_������PSM�ł����C�����ɂ��ĐG��Ă����܂��B �܂��́C�J�����s���p���ăV�[�����ϊ���̋�Ԃɕϊ����܂��B���̂Ƃ��ɁC�ϊ�����̂ɗp�����s����g���ă��C�g���ϊ����C�V���h�E�}�b�v�����܂��B���̂Ƃ��ɋC������̂̓��C�g�͕������C�g(directional light)���g���Ƃ������Ƃł��B���Ȃ킿�C�������_�ł̓_�����Ƃ��čl����Ƃ������Ƃł��B�������������ɂ͓������W�n��w������0�Ƃ��Ď�舵���������ƂɂȂ�܂��B����ɁC�C�����Ăق����̂́C�����ϊ���p���邽�߁C��قǏq�ׂ��������ω�����Ƃ�����肪��������\��������Ƃ������Ƃł��B���̂悤�ɏ������ς���Ă��܂��̂́C�������C�g���ϑ��҂̌��ɂ���ꍇ�ł��B����āC����肷��K�v������܂��B���̔���́C�P���ɃJ�����̎����x�N�g���ƃ��[���h��Ԃł̕������C�g�̃x�N�g���̓��ς��Ƃ�Δ���ł��܂��B�����C�J�����̌�납�烉�C�g��������Ɣ��肳�ꂽ�ꍇ�́C�������������Ȃ�悤��z���ɉ����Ď��쐍����ړ��������dz�������C�X���C�h�o�b�N�����܂��B�������X���C�h�o�b�N������ƁC�j�A���ʂƃt�@�[���ʂ̈ʒu���ς���Ă��܂��܂��̂ŁC�j�A���ʂƃt�@�[���ʂ̈ʒu���ς��Ȃ��悤�Ɉړ���dz�𑫂��Ďˉe�s����쐬���Ȃ����܂��B�ˉe�s�쐬�ł�����C�r���[�s��Ɗ|�Z���āC�r���[�ˉe�s����v�Z���܂��B���[���h��Ԃ̕������C�g�͂��̌v�Z�����r���[�ˉe�s����g���āC�����ϊ���̋�Ԃɕϊ����܂��B�s��������邱�Ƃɂ���āC�����ϊ���̃��C�g�́C���̐}�̂悤�ɓ_�����ɂȂ�ꍇ�ƁC���������ɂȂ�ꍇ���łĂ��܂��B    �����ϊ���̃��C�g��w������0�̏ꍇ(��}��Case 1)�͕��s����(parallel light)�ł���̂ŁC�P�ʃL���[�u���ނ悤�ȕ��s���쐍����\�z���܂��B�܂�CglOrtho()�Ȃǂ��g���ă��C�g�̎ˉe�s����쐬���܂��B���C�g�̃r���[�s��͓����ϊ���̋�ԂȂ̂ŁC���_�ʒu��(0, 0, 0)�ɂȂ�܂��B�����_�́C�����ϊ���̋�Ԃł̕������C�g����������ɂȂ�̂�(-ppsLight.x, -ppsLight.y, -ppsLight.z)�������CppsLight�͓����ϊ���̋�Ԃł̃��C�g�̈ʒu�Ƃ��܂��B���̃p�����[�^�ɂ���ă��C�g�̃r���[�s����쐬���܂��B �����ϊ���̃��C�g��w������0�łȂ��ꍇ�́C������(ppLight.x/ppsLight.w, ppsLight.y/ppsLight.w, ppsLight.z/ppsLight.w)�̗L���ʒu�ɂ���܂����Cw>0�ł���ꍇ(��}��Case 2)�́C�����ϊ���������ł����Cw<0�̏ꍇ(��}��Case 3)�̓��C�g�̏����_�ɂȂ�̂ŁCz��-1�{���Ĕ��]�����܂��B�����āC���C�g�̎ˉe�s��ƃ��C�g�̃r���[�s����쐬���܂��B�r���[�s����쐬����ꍇ�́C���_���ϊ���̃��C�g�̈ʒu�ɂ��č쐬���܂��B �@�����Ⴒ����Ə����܂������C�ŏI�I�ɃV���h�E�}�b�v�̍쐬�ɗp����s��Mshadow�͎��̂悤�Ȍ`���ɂȂ�܂��B  ���̏�̌`���ŏ����ꂽ�s����g���ăV���h�E�}�b�v��`�悵�܂��B�[�x�l�̔�r������Ƃ����C���̍s���p���܂��B �^���R�[�h�ŏ����ƁC�����V���h�E�}�b�v���쐬�ɂ���̂ɗp����s��̋��߂�ߒ��́C���̂悤�ɂȂ�܂��B

�@�J�����̃r���[�s��쐬;

�@�J�����̎ˉe�s��쐬;

�@if( NearClip < zNearMin )

�߂�����ߕ��ʂ�������邽�߂̃I�t�Z�b�g���Z�o;

�@�����x�N�g�������߂�;

�@���[���h��Ԃ̃��C�g�Ǝ����x�N�g���̓��ς����߂�

�@if�i�J�����̌�납�烉�C�g�������邩�ǂ����j

�J��������ނ�����ʂ��Z�o;

�@if (�J��������ނ����邩�ǂ����j

�@{

z���ɉ����ăJ���������;

�J��������̒��߂����āC�ˉe�s����č쐬;

�@}

�@(�J�����̃r���[�ˉe�s��) = (�J�����̃r���[�s��) * (�J�����̎ˉe�s��);

�@(�����ϊ���̋�Ԃł̃��C�g) = (���[���h��Ԃ̃��C�g) * (�J�����̃r���[�ˉe�s��);

�@// Case 1�ɊY��

�@if ( �����ϊ���̋�Ԃł̃��C�g��w������0�̏ꍇ���ǂ��� )

�@{

//�@�����ϊ���̃��C�g�͕��s����

���C�g�̃r���[�s����쐬;

���C�g�̎ˉe�s����쐬;

�@}

// Case 2, 3�ɊY��

�@else

�@{�@

//�@�����ϊ���̃��C�g�͓_����

if ( �����_�ł��邩�ǂ��� )

�@�@z�Ƀ}�C�i�X1���|���Ĕ��]; // Case 3�ɊY��

���C�g�̃r���[�s����쐬;

�@ ���C�g�̎ˉe�s����쐬;

�@}

�@(���C�g�̃r���[�ˉe�s��) = (���C�g�̃r���[�s��) * (���C�g�̎ˉe�s��);

�@(�����V���h�E�}�b�v�̍s��) = (�J�����̃r���[�ˉe�s��) * (���C�g�̃r���[�ˉe�s��);

�@(�ŏI�I�ɗp����s��j= (���[���h�s��) * (�����V���h�E�}�b�v�̍s��);

�@�����ǂ�����������������ł����C�����V���h�E�}�b�v����舵���Ă݂܂����B�������łɑ��̃T�C�g�ŏЉ��Ă���C���C�g��ԓ����V���h�E�}�b�v(Light Space Perspective Shadow Maps)��CSIGGRAPH2008�Ŕ��\���ꂽ�ΐ������V���h�E�}�b�v(Logarithmic Perspective Shadow Maps)�Ƃ�������悤�Ȃ����Ă݂����ł��ˁB ���@Download

�{�\�[�X�R�[�h����уv���O�������g�p�������Ƃɂ��@���Ȃ鑹�Q������҂͐ӔC���܂���B

�{�\�[�X�R�[�h����уv���O�����͎��ȐӔC�ł��g�p���������B �v���O�����̍쐬�ɂ�Microsoft Visual Studio 2008 SP1 Professional��p���Ă��܂��B |